Биометрия и подделка людей | проблема дип-фейков

Содержание:

- Как обмануть системы распознавания лиц

- В чем преимущества deepfake-технологий

- Наиболее известные дипфейки

- В чём тут опасность?

- Как распознать дипфейк?

- Биометрия в реальной жизни

- Восстановление после нитевой подтяжки

- Мы сами помогаем создать свой дипфейк

- Что такое Deep Fake и насколько это опасно для биометрии

- Показания и противопоказания к процедуре

- Что такое дипфейк и как его применяют?

- Почему дипфейков становится все больше

- Как вести себя в соцсетях, чтобы не стать жертвой фейковой информации

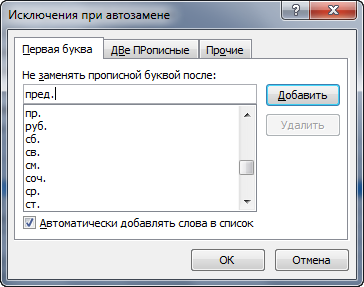

Как обмануть системы распознавания лиц

Аппаратные токены становятся все более популярными в мире технологии блокчейн. Биометрические данные, такие как отпечатки пальцев, распознавание лиц или распознавание лиц, — это мощные способы затруднить доступ других к вашим данным. Эта статья призвана объяснить, что такое биометрический аппаратный токен, как они работают и как их можно купить.

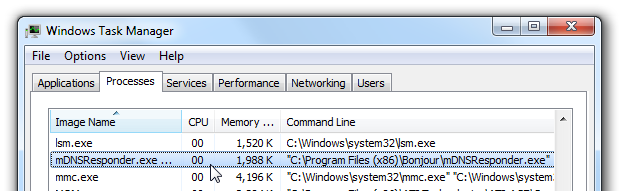

Чтобы не стать жертвой некорректной работы систем распознавания, некоторые люди стараются найти способы для их обмана.

В 2017 году директор по распространению технологий «Яндекса» Григорий Бакунов разработал специальную систему макияжа, якобы помогающего обмануть нейросети. Для этого он использовал алгоритм, подбирающий образ по принципу антисходства. Примерно в том же ключе действовали участники протестов в Лондоне в 2020 году: они пытались обмануть системы распознавания лиц с помощью цветных патчей на лице.

Пост из инстаграм the Dazzle Club

Исследователи также занимаются разработками, которые не позволяют ИИ учиться на личных данных, говорится в статье MIT Technology Review. Один из первых представленных инструментов — это программа Fawkes, которую разработала Эмили Венгер из Чикагского университета. «Мне не нравится, когда люди берут у меня то, что не должно им принадлежать», — объясняет она свою мотивацию.

Большинство подобных инструментов используют один и тот же алгоритм: они вносят в изображения небольшие изменения, которые незаметны для человеческого глаза, и заставляют ИИ неправильно определять лица на фотографиях. Этот метод очень близок к состязательной атаке, когда небольшие изменения данных могут привести модели глубокого обучения к ошибкам.

Благодаря такому подходу современные системы распознавания лиц перестанут работать. В отличие от предыдущих попыток запутать ИИ (например, нанесение краски на лица), новая технология оставляет изображения неизменными для зрительного восприятия человека. Программа Fawkes на сайте Чикагского университета для свободного скачивания и использования. С тех пор её загрузили свыше 500 тысяч раз.

Автор Fawkes Эмили Венгер и её коллеги протестировали свой инструмент на известных коммерческих системах распознавания лиц — Amazon AWS Rekognition, Microsoft Azure и Face++. В небольшом эксперименте с набором данных из 50 фотографий алгоритм был эффективен на 100 %. Позднее Fawkes не позволяла моделям, обученным на изменённых изображениях людей, распознавать эти же лица на свежих снимках. То есть небольшие изменения, внесённые в фотографии, помешали инструментам сформировать точное представление о лицах.

Fawkes может помешать новой системе распознавания определять людей по фото. Но у программы не получится противодействовать существующим системам, которые уже были обучены на незащищённых изображениях. Впрочем, технология постоянно совершенствуется.

Создатель Fawkes считает, что инструмент LowKey, разработанный Валерией Черепановой и ее коллегами из Университета Мэриленда, может решить эту проблему. LowKey расширяет возможности Fawkes: он противодействует системам, основанным на более сильном виде состязательной атаки, а также обманывает предварительно обученные коммерческие модели. Как и Fawkes, LowKey доступен как веб-сервис.

Большинство подобных инструментов, включая Fawkes, используют один и тот же базовый подход: в изображение вносятся микроизменения, которые трудно заметить человеческим глазом, но они нарушают работу ИИ. В частности, если дать Fawkes на ввод серию фотографий, он добавит к ним искажения на уровне пикселей, которые не позволят современным системам распознавания лиц определить, кто изображён на снимках.

Намеренное «загрязнение» данных может затруднить для компаний тренировку моделей машинного обучения, предположил директор по продуктам компании Ivideon Заур Абуталимов в разговоре со Skillbox Media.

«Однако отличием этих новых методов является то, что они работают с фотографиями одного человека. Такие инструменты, как Fawkes, могут помешать новой системе распознавания лиц распознать именно вас, но они не помешают существующим системам, которые уже обучались на ваших „незащищённых“ изображениях», — подчеркнул Заур Абуталимов.

Преподаватель Deep Learning School, автор блога об искусственном интеллекте и нейронных сетях Татьяна Гайнцева рассказала Skillbox Media, что инструменты Fawkes и LowKey могут быть перспективными, но не стоит ожидать от них абсолютной эффективности.

В чем преимущества deepfake-технологий

Дипфейки способны позитивно воздействовать на человека и общество в целом. Синтетические медиа дают людям голос, зрение, слух и возможность моделировать реальность.

#1. AI-синтетическое медиа делает мир доступным

С помощью AI можно создавать инструменты, которые дополняют основные способности человека — слух и зрение. Например:

#2. Продвинутые технологии в искусстве

Голливуд широко использует инструменты создания спецэффектов CGI, VFX и SFX, чтобы моделировать искусственные, но реалистичные миры и добавить в картину элемент сторителлинга. В фильме «Форрест Гамп» герой встречает Джона Кеннеди и других исторических персонажей. Здесь использовались именно CGI-технологии.

Музей Сальвадора Дали в Сент-Питерсберге, штат Флорида, в 2019 году открыл выставку Dalí lives. Основной идеей экспозиции было «вернуть к жизни» культового художника, дать возможность посетителям почувствовать его присутствие. В музее можно было даже сделать селфи с Дали.

#3. Свобода слова и прогнозирование

Синтетические медиа способны содействовать правозащитникам и журналистам. Эти социальные деятели могут оставаться анонимными при деспотических или диктаторских режимах. Например, в соцсетях можно запостить конфиденциальный ролик о злодеяниях правительства, но при этом на видео будет синтетическая личность.

Проект UNICEF и MIT Deep Empathy использует deep learning для изучения сирийских регионов, затронутых конфликтом. Затем программа моделирует, как будут выглядеть города по всему миру в условиях аналогичного конфликта. В рамках проекта были созданы искусственные модели Бостона, Лондона и других мест. Так люди могут увидеть, какие бедствия и страдания приносит война.

Да, дипфейки можно использовать для распространения дезинформации, фальсификации и мошенничества. И да, создатели дипфейк-контента на Youtube, Reddit и TikTok соревнуются между собой, надеясь заработать. Все больше драмы, все больше шокирующих ситуаций. Однако выбор всегда остается за вами. Хотите ли вы видеть и слышать то, что вам показывают? Хотите ли поверить в это?

Наиболее известные дипфейки

Анализ показывает, что 96% от общего количества синтезированных роликов составляет порно. Однако сейчас наибольший интерес для производителей дипфейков представляют известные политики. Подлинные видео, на которых присутствуют авторитетные люди, подвергают изменениям и наполняют компрометирующими заявлениями.

Самыми нашумевшими дипфейками последнего времени являются:

- видео с пьяной Нэнси Пелоси, спикером палаты представителей конгресса США;

- видео с президентом США Дональдом Трампом, который жестко высказывается против инициатив, связанных с защитой климата;

- видео с экс-президентом США Бараком Обамой, который называет действующего президента Трампа «засранцем»;

- видео с главой Facebook Марком Цукербергом, где он говорит о своем мировом господстве.

Конечно, некоторые дипфейки не приносят никому вреда. Они имеют шутливый, развлекательный характер и подобны фотошопу или другому софту, работающему с изображениями ради забавы. Например, на Youtube можно найти ролики, где в известных фильмах лица главных героев заменены лицами других звезд Голливуда.

Например:

- Терминатор в исполнении Сильвестра Сталлоне;

- Брюс Ли в роли Нео из «Матрицы»;

- Джим Керри вместо Джека Николсона в «Сиянии».

Дипфейк-технологии также используются в рекламе для привлечения внимания к социальным проблемам. Например, британская телекомпания выпустила информационный ролик с участием известного английского футболиста Дэвида Бекхэма о малярии. Благодаря синтезированному видео звезда без акцента заговорила на 9 иностранных языках: искусственный интеллект подстроил артикуляцию Бекхэма под запись речи, которую произносили носители.

Говорить об однозначном вреде этой технологии нельзя. Слишком многое зависит от цели ее применения.

В чём тут опасность?

С распространением deep fake появилась опасность дискредитации любого пользователя, фото которого есть в сети. Первыми под огонь попали публичные личности, изображений которых достаточно много в открытом доступе. Например, лицо актера Николаса Кейджа давно стало мемом, а сам он известен неразборчивостью в выборе ролей. Благодаря deep fake лицо Николаса Кейджа поместили практически во все эпизоды известных фильмов. Например, он стал Лоис Лейн из «Человека из стали»:

Учитывая количество фото, которые мы заливаем в социальные сети, недостатка в материале для deep fake нет. Проблема в том, что в будущем пользователи, которые не смогут доказать, что их не было на определённом видео, может, например, грозить тюремный срок.

По мнению Адиля Жалилова, руководителя factсheck.kz, в зависимости от контента такие видео могут быть как безобидными, так катастрофически опасными.

По его словам, если население будет не в курсе о возможностях и вообще о существовании deep fakes, то любое такое поддельное видео с провокационным контентом может «вложить в уста» любому политику или представителю какого-либо этноса любой месседж. Это может породить деструктивный импульс и спровоцировать конфликты. Любая попытка властей реагировать, объяснить технологию deep fakes постфактум будет запоздалой в такой ситуации.

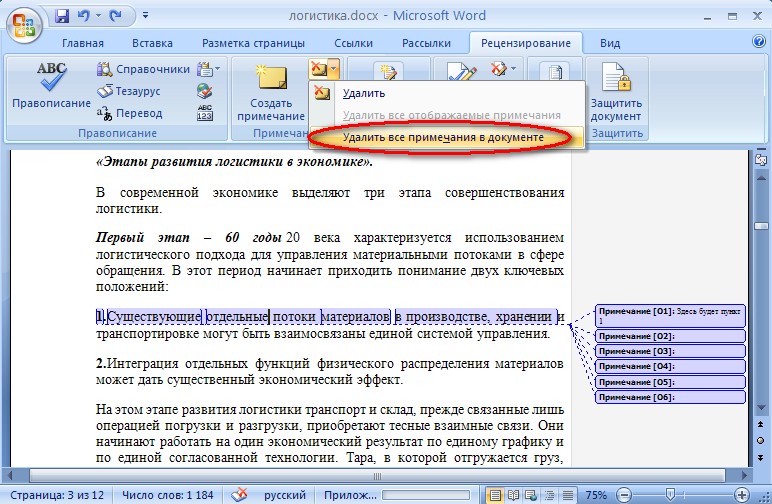

Как распознать дипфейк?

Александра Мурзина ведущий специалист по машинному обучению в Positive Technologies

Надежных способов отличить дипфейк от настоящего видео нет. Однако, так как технология уже не нова, то техники распознания дипфейков есть.

Раз нейронные сети применяют для создания дипфейков, то их можно использовать и для решения обратной задачи — детектирования поддельных видео. Самый распространенный подход — показать нейросети два видео: оригинальное и созданное с помощью дипфейк-технологии. Тогда нейросеть, которая учится, начнет различать неуловимые человеком признаки сгенерированного видео.

Другой интересный подход к видео — это извлечение временных признаков между кадрами видео, так как известно, что эта согласованность не достигается при генерировании видео. То есть при просмотре видео вы не заметите, но при покадровом анализе можно увидеть недостатки. Так и обучают нейросети — обрабатывать кадры на большой скорости они могут эффективнее человека.

В теории результаты выглядят интересными, однако использовать в повседневной жизни такие разработки трудно, они требуют вычислительных ресурсов, а значит, недоступны обычным пользователям. Но благодаря тому, что этот феномен изучается, техниками анализа данных получены некоторые интересные результаты, которые могут быть полезны и простому пользователю. Ребята из Массачусетского технологического института (MIT) создали специальный сайт, где можно потренироваться. На основе своих исследований специалисты из MIT предложили ряд рекомендаций, которые могут помочь отличить дипфейк от реального видео.

Обычно с помощью дипфейков меняют именно лицо. Оно не всегда может подходить к телу, и если это известный человек, то можно сравнить его телосложение в других источниках. Кожа может быть неестественно гладкой

Стоит обратить внимание на соответствие кожи возрасту человека. В области глаз и бровей могут быть неестественные тени, во время видео они не всегда могут передавать естественные физические изменения. Очки и аксессуары. На очках могут быть странные блики, а аксессуары могут быть странно сгенерированы

На фотографиях это очень заметно. Все еще не всегда получается сделать волосы достаточно естественными. Могут исчезнуть или появиться бакенбарды, неестественная граница волос и кожи. Обращаем внимание на движение глаз: соответствуют ли они ситуации, которая происходит, и тому, чего вы ожидаете.

Биометрия в реальной жизни

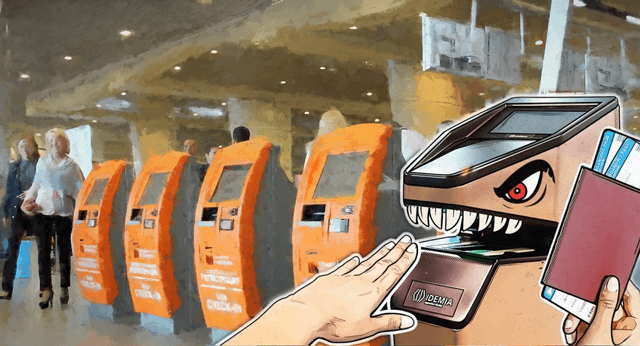

Помимо научно-фантастических фильмов и военного применения, автоматическую проверку подлинности биометрических данных можно использовать в двух случаях.

В некоторых банкоматах используют сканы отпечатка ладони, а некоторые телефонные услуги идентифицируют пользователей на основе голоса. Вторым типом биометрической защиты, встречающимся каждый день, являются сканеры, встроенные в электронные устройства, такие как ноутбуки и смартфоны. Фронтальная камера может быть использована для обнаружения лица, а специальный датчик может сканировать отпечатки пальцев. Многие системы также используют голосовую авторизацию.

Помимо указанных выше проблем, биометрические решения имеют свои ограничения, связанные с мощностью процессора, возможностями датчика или физическими размерами. Чтобы обойти эти ограничения, производители должны уделять больше внимания безопасности системы и её устойчивости. Поэтому вы легко можете обмануть некоторые сканеры с помощью мокрой бумаги с напечатанным отпечатком пальца. А когда в игру вступают реальные деньги, мошенники могут даже начать производить искусственные пальцы.

С другой стороны, законные пользователи часто должны перемещать свои пальцы много раз, чтобы получить доступ – большинство датчиков может работать не правильно, если палец мокрый, грязный или имеет царапины и ожоги.

Системы распознавания лица редко могут различить истинные лица людей с фотографий (хотя некоторые системы проверяют, имеют ли они дело с живым человеком, например, требуют улыбнуться). Однако, во время распознавания лица для разблокировки мобильного устройства эти программы часто демонстрируют чувствительность к условиям освещения и другим факторам окружающей среды. Следовательно, Вы должны иметь «план B» в виде обычного пароля, в противном случае вы не разблокируете устройство в темноте.

Большинство производителей систем голосовой авторизации говорит, что они могут обнаружить обман – как запись, так и мошенников. Но, в действительности, только самые мощные системы выполняют все необходимые сложные вычисления, а некоторые исследователи утверждают, что программы для изменения голоса могут обмануть системы авторизации в 17% случаев. На мобильном устройстве трудно выполнить полный и независимый анализ в режиме реального времени, потому что он потребует помощи со стороны облака, что, в свою очередь, зависит от качества подключения к интернету и подвергает устройство риску атаки типа man-in-the-middle.

Сочетание многих неудобства для легальных пользователей и недостаточного уровня безопасности сдерживает повсеместное внедрение биометрической аутентификации и не заменяет традиционных паролей и PIN-кодов. Безопасная и надежная проверка личности с помощью биометрии возможна только в контролируемых условиях, например, при пересечении границы в аэропорту или в пункте прохождения контроля при входе в компанию.

Восстановление после нитевой подтяжки

Реабилитация после тредлифтинга довольно быстрая. Они занимает от 2 до 7 дней, у некоторых пациентов могут появиться гематомы и отечность из-за его индивидуальных особенностей. Они проходят через несколько дней.

Для того, чтобы лифтинг-эффект был максимальным и сохранялся долгое время, стоит соблюдать элементарные рекомендации врачей:

- В течение 3-5 дней не посещать бассейн;

- В течение 3 недель не ходить в сауну и солярий;

- Не спать на животе 2 недели;

- Избегать массажа лица 2 месяца;

- Отказаться от инъекционных, лазерных и других салонных процедур с согревающим эффектом (для избежания рассасывания нитей);

- Ограничить мимическую активность на 2-3 недели;

Кроме того, врачи рекомендуют пациентам самостоятельно обрабатывать антисептиком места вколов в течение нескольких дней. И при необходимости назначают противовоспалительные мази и таблетки.

Мы сами помогаем создать свой дипфейк

Но хорошее дело фейком не назовут. Технология уже успешно используется в мошеннических схемах.

В марте 2019 года генеральный директор британской энергетической компании перечислил €220 000 после телефонного разговора, в котором знакомый голос высокопоставленного партнера из Германии потребовал перевести деньги венгерскому поставщику.

В начале 2020 года управляющий банком в Гонконге также по звонку перевел $35 млн на счет в США тому, кого принял по голосу за директора компании, с которым разговаривал накануне. Расследование показало, что мошенники использовали технологию «глубокого голоса» для имитации речи директора.

В России объектами клонирования становились бизнесмены Дмитрий Мацкевич и Олег Тиньков. Видеоролики с их дипфейками использовались для рекламы несуществующих супердоходов и содержали ссылки на мошеннические сайты.

Сегодня технология подделки человека стала максимально доступной и дешевой. Также на руку мошенникам играет тот факт, что мы все больше общаемся на расстоянии — с помощью мессенджеров, звонков, соцсетей. Все, что вы выложите в Сеть, может быть использовано для создания дипфейка. И выходит, мы сами помогаем мошенникам, когда размещаем фотографии, рассказываем, с кем общаемся и где бываем. Чем больше хороших видео выложили, тем более похожей выйдет подделка.

«Многие думают: «А что плохого, если люди узнают, где я отдыхаю? А что плохого, если я буду везде делать селфи? Это же, наоборот, хорошо. Смотрите, какая я красивая. Или: смотрите, какой я успешный». Но это означает, что кто-то может этим воспользоваться. Кто угодно может скормить ваши фотографии нейросети и создать копию. Люди должны задуматься о том, каким выглядит новый баланс приватности и публичности», — говорит Василий Буров.

По словам эксперта, сбор разнообразной биометрии может сильно усугубить ситуацию: «Если у нейросети есть хорошие снимки нашей сетчатки глаза, значит, она сумеет изобразить такую же. Если у нее много записей нашего голоса, тогда она сумеет изобразить такой же. Если у нее много наших изображений, тогда она сможет нас имитировать. А этого всего становится много, и оно бесконтрольно от нас уходит».

Что такое Deep Fake и насколько это опасно для биометрии

В 2019 году мир охватила истерия под названием Deep Fake, когда с помощью технологий глубокого машинного обучения (Deep Learning) начали создаваться многочисленные аудио- и видео-подделки на реальных людей. При этом используется генеративно-состязательные сети (GAN, Generative Adversarial Network), когда одна нейросеть генерирует подделку, а другая – распознает ее. Таким образом, обе сети тренируют друг друга, постепенно доводя результат до совершенства. Пока самым ярким примером практического и неправомерного применения этой технологии Machine Learning является случай с зарубежной энергетической компанией, которая потеряла около 220 тысяч евро, переведя их на счет злоумышленников в следствие телефонного звонка, где голосом руководителя фирмы было отдано распоряжение на перевод денег стороннему контрагенту. Характерно, что был правдоподобно имитирован не только голос начальника, но и его манера разговора, в частности, немецкий акцент . Аналогичным образом с помощью Deep Fake возможна генерация видео в режиме онлайн, как это было продемонстрировано во второй половине 2019 года на конференции в Массачусетском технологическом институте .

Дополнительную опасность неправомерного использования GAN-моделей добавляет способность этих алгоритмов Machine Learning обучаться на разнородных аудио, видео и изображениях, которых полно в открытом доступе. Так могут быть созданы фейковые записи известных людей, знаменитостей и политиков, что влечет социальные, финансовые и политические риски. Кроме того, данная технология машинного обучения также потенциально опасна и для простых обывателей, которые используют лицо и голос в качестве биометрических идентификаторов, например, в российской ЕБС. Подробнее об этой системе биометрии и ее практическом внедрении в нашей стране мы рассказывали здесь.

Поэтому, даже если сгенерированные с помощью Deep Fake и опубликованные аудио и видеозаписи можно рассматривать как высокотехнологичный монтаж, то для защиты от таких приложений Machine Learning в реальных Big Data системах биометрии нужны дополнительные меры cybersecyrity. К ним относятся многофакторная аутентификация, защита биометрических шаблонов и кратная верификация, о которых мы поговорим в следующей статье.

Обеспечение информационной безопасности биометрии – одна из главных задач технологий Big Data и Machine Learning

Другие практические аспекты информационной безопасности больших данных, включая биометрию на базе машинного обучения, рассматриваются на наших образовательных курсах в лицензированном учебном центре обучения и повышения квалификации ИТ-специалистов (менеджеров, архитекторов, инженеров, администраторов, Data Scientist’ов и аналитиков Big Data) в Москве:

- BDAM: Аналитика больших данных для руководителей

- DSEC: Безопасность озера данных Hadoop

Смотреть расписание Записаться на курс

Источники

- https://www.vedomosti.ru/technology/articles/2018/03/28/755116-obmanut-sistemi

- https://hitech.newsru.com/article/24may2017/iris

- https://hitech.newsru.com/article/10mar2016/fingerprint

- https://nplus1.ru/news/2018/12/28/vein

- https://nplus1.ru/news/2019/04/08/galaxy-s10-fingerprint

- https://www.anti-malware.ru/news/2019-05-28-1447/29755

- https://www.securitylab.ru/news/485851.php

- https://www.securitylab.ru/blog/company/PandaSecurityRus/347085.php

- https://www.plusworld.ru/journal/2019/plus-9-2019/obman-sistem-biometricheskoj-identifikatsii-i-sposoby-protivodejstviya/

Показания и противопоказания к процедуре

У процедуры нитевого лифтинга есть совершенно четкие показания и противопоказания.

Нитевая подтяжка показана в таких случаях:

- Появление морщин, в том числе, и глубоких;

- Выраженные носогубные складки;

- «Поплывший» овал лица и брыли;

- Второй подбородок:

- Нависание века;

- Опущение уголков рта;

- Целлюлит (если нити устанавливаются на теле);

- Дряблость кожи (например, на руках и бедрах).

Противопоказания для нитевого лифтинга:

- Острые заболевания на момент проведения процедуры (кишечные, вирусные, кожные, а также гипертонический криз);

- Беременность и грудное вскармливание;

- Высокий сахар в крови;

- Плохая свертываемость крови;

- Заболевания крови;

- Выраженный избыток кожных тканей.

Что такое дипфейк и как его применяют?

Слово deepfake (дипфейк) составлено из двух терминов: «глубинное обучение» (англ. deep learning) и «подделка» (англ. fake). Нейросеть генерирует чье-то изображение и накладывает его на исходное. С помощью этой технологии можно подделать не только видео, но и любое изображение на экране: например, по видеосвязи общаетесь вы, а ваш собеседник видит (и слышит) кого-то другого. И хорошо, если это будет безобидный розыгрыш.

Для создания дипфейка достаточно нескольких качественных фотографий и записи голоса. Еще лучше, если есть видео: тогда искусственный интеллект можно научить воспроизводить мимику и движения.

Дипфейк может быть даже полезным. Самая очевидная сфера применения — кино.

Даже больше, чем в кино, впечатляет демонстрация возможностей технологии в соцсетях. В 2021 году в TikTok появился клон Тома Круза. Он играет в гольф, поет под гитару, отращивает усы и отпускает шутки про Горбачева.

Подделку не отличил даже канадский музыкант Джастин Бибер, который записал двухчасовой видеоответ на один из роликов дипфейка и пытался научить кинозвезду правильно играть на гитаре. Все это он выкладывал в сториз в своем инстаграме и тегал настоящий аккаунт Тома Круза. Когда фанаты наконец сообщили об ошибке, Бибер написал: «Это не настоящий Том Круз? Лол, ну ладно, это по‑прежнему забавно».

Пародийный аккаунт @deeptomcruize, демонстрирующий силу новых технологий, создал художник по визуальным эффектам Крис Уме в соавторстве с актером и имитатором Майлзом Фишером. Клон Тома Круза моложе оригинала и намного популярнее по числу подписчиков.

Из видео ниже следует, что дипфейк, в отличие от вампира, отражается в зеркале, но есть нюансы:

Еще одна возможность дипфейка (безопасная, хотя и жутковатая) — «оживление» мертвецов. Теоретически эта технология способна помочь пережить утрату близкого человека в общении с виртуальной копией. А те, кто мечтает о цифровом бессмертии, могут заранее позаботиться о вечной жизни своего «аватара».

Почему дипфейков становится все больше

Эксперты предупреждают, что в течение полугода ожидается значительный прогресс в технологии производства дипфейков. Это связано со стремительным развитием искусственного интеллекта и нейросетей.

Уже сейчас есть возможность создавать крупноплановые дипфейки высокого качества без значительных временных и финансовых вложений. Постепенно уходят мимические нестыковки, монотонность речи, нереалистичные движения и другие артефакты. Дипфейки становятся все более правдивыми.

Заменить лицо на фото благодаря специальным программам теперь может любой человек. Так и дипфейки постепенно становятся доступными для массового производства. Например, FaceApp-приложения уже вовсю используют эту технологию. Также в интернете можно найти руководства, обучающие пользователей подменять лица в видео категории 18+.

В ближайшее время ожидается широкое распространение дипфейков в рекламной сфере, индустрии развлечений, кино. Вместе с тем сильно возрастет угроза создания фейковых новостей.

Специалисты говорят, что перед производителями подобных материалов рано или поздно встанет вопрос о легализации контента. Может появиться такое понятие, как «прайс на лицо знаменитостей», то есть рекламу или кино уже не нужно будет снимать с их участием, достаточно будет лишь указывать, что представленное видео ― дипфейк.

Как вести себя в соцсетях, чтобы не стать жертвой фейковой информации

Человек, который ведёт социальные сети для собственного удовольствия, и человек, который продвигает с их помощью персональный бренд, в разной степени рискуют из-за распространения фейковой информации. Первый в худшем случае может получить пару нелестных комментариев и испорченное настроение, а второй — удар по деловой репутации, снижение доверия и количества подписчиков и, как следствие, снижение продаж.

Поэтому особенно важно проверять информацию прежде, чем писать или давать оценочное суждение кому-то или чему-то. Но все мы живые люди и, даже если отлично натренировали своё критическое мышление, в один прекрасный день можем сорваться и допустить ошибку

Расшарить похожую на правду информацию, получить десятки или даже сотни негативных комментариев, развязать ненужную дискуссию. Чтобы не попасть в неприятную ситуацию или не усугубить её, придерживайтесь следующих правил.

Не поддавайтесь эмоциям, или правило 10 минут

Не предпринимайте никаких шагов в состоянии импульса, если информация задела вас за живое, возмутила, испугала и т. д. Если возникло непреодолимое желание включиться в процесс, специалисты рекомендуют использовать «правило 10 минут», в течение которого нужно оставить соцсети в покое и заняться чем-нибудь другим. Как правило, за это время эмоциональный заряд ослабевает и желание шерить информацию и писать гневные посты сходит на нет.

Не бойтесь извиняться

Тем более, публично. Тем более, если действительно оплошали и неправдивая информация, которую вы разместили в своём аккаунте, вызвала бурные обсуждения и включённость аудитории. Я много раз видел, как публичные персоны, выставив сегодня очень убедительный пост со ссылкой на исследование или новость, на следующий день писали опровержение и приносили извинения своим подписчикам. Такой поступок воспринимается аудиторией намного лояльнее и вызывает меньше негатива, чем молчание.

Проверяйте информацию — точность фактов важнее сенсации

Определение фейка подразумевает не только осознанные подделки и симуляции, но и небрежность, опечатки и технические ошибки. Уходя в массовое сознание, они становятся ложной реальностью. Поэтому всегда проверяйте написание имён, профессий и званий упомянутых людей, сверяйте даты, названия и адреса. Тогда вы сами сумеете избежать ошибки и ваша репутация как эксперта не пострадает.